1. MCPの基本概念と背景:AIを現実のデータにつなぐ標準規格

1-1. AIが直面する「孤立状態」の課題

大規模言語モデル(LLM)の**コンテキスト(文脈)とは、モデルが回答を生成する際に参照できる入力情報の集合を指します。従来のChatGPTなどのAIアシスタントは与えられたテキストだけを手がかりに応答していました。しかし、「AIが社内データや外部ツールに直接アクセスできない」**という孤立状態が大きな課題でした。

たとえば社内のドキュメントやデータベースに含まれる知識をAIに活用させるには、開発者がカスタム接続(プラグインやスクリプト)を実装しなければなりません。しかもシステムごとに連携方法が違うため、M×Nの統合問題(それぞれの組み合わせごとに統合実装)が発生していたのです。

1-2. MCP誕生の経緯とUSB-Cに例えられる統一規格

この課題を解決するために、Anthropic社が2024年末に発表したのが**MCP(Model Context Protocol)です。MCPは、AIアシスタントと外部のデータ源やツールを結ぶためのオープン標準プロトコルであり、AIと他システム間のやり取り(データやツールの呼び出し)を統一ルールで定義します。

この仕組みは、さまざまなデバイスを同じポートで接続できるUSB-Cのように、「どのAIアプリとどんなデータソースでも同じ手順で接続できる」**ことを目指しています。従来は個別統合を「M×N」で考える必要がありましたが、MCPにより「M+N」の単純足し算的な統合が実現されると期待されています。

1-3. Language Server Protocol (LSP)との類似点

MCPの発想は、プログラミング言語用の**Language Server Protocol (LSP)**に似ていると言われます。LSPは「各エディタが各プログラミング言語に対応するためにバラバラの実装を行う」問題を解決し、1つの標準プロトコルにまとめた成功例です。MCPはAIと外部システムの「分断された接続問題」を統一し、同様のメリットを提供します。

1-4. 技術的概要:クライアント-サーバー方式とオープンソースSDK

MCPはクライアント-サーバー型プロトコルであり、AIを搭載したアプリ(MCPクライアント)がデータソースごとに用意されたMCPサーバーと通信します。通信にはJSON-RPCフォーマットを採用し、リクエストとレスポンスの型が標準化されています。

AnthropicはMCPをオープンソースで公開し、PythonやTypeScript、Java、C#など複数言語向けの公式SDKを提供しています。誰でも実装しやすい環境が用意されており、この標準を広めることで、AIと外部データの分断をなくすことを目指しています。

2. ClaudeにおけるMCPの特徴と利点:長大なコンテキストと構造化された情報

2-1. 特筆すべき大容量コンテキスト:最大100Kトークン

ClaudeはAnthropic社のLLMベースAIアシスタントであり、非常に長いコンテキストを取り扱える点が大きな特徴です。2023年に、コンテキスト長が9,000トークンから100,000トークン(約75,000語)へ大幅に拡大されました。

Anthropicのデモでは、『グレート・ギャツビー』全文(約72Kトークン)を一度に読み込ませ、一文だけ変えた部分をわずか22秒で特定することに成功しています。これにより、複数の長文を同時に比較・分析したり、膨大なドキュメントを横断的に要約することが可能です。

2-2. MCPで実現する「構造化されたコンテキスト」

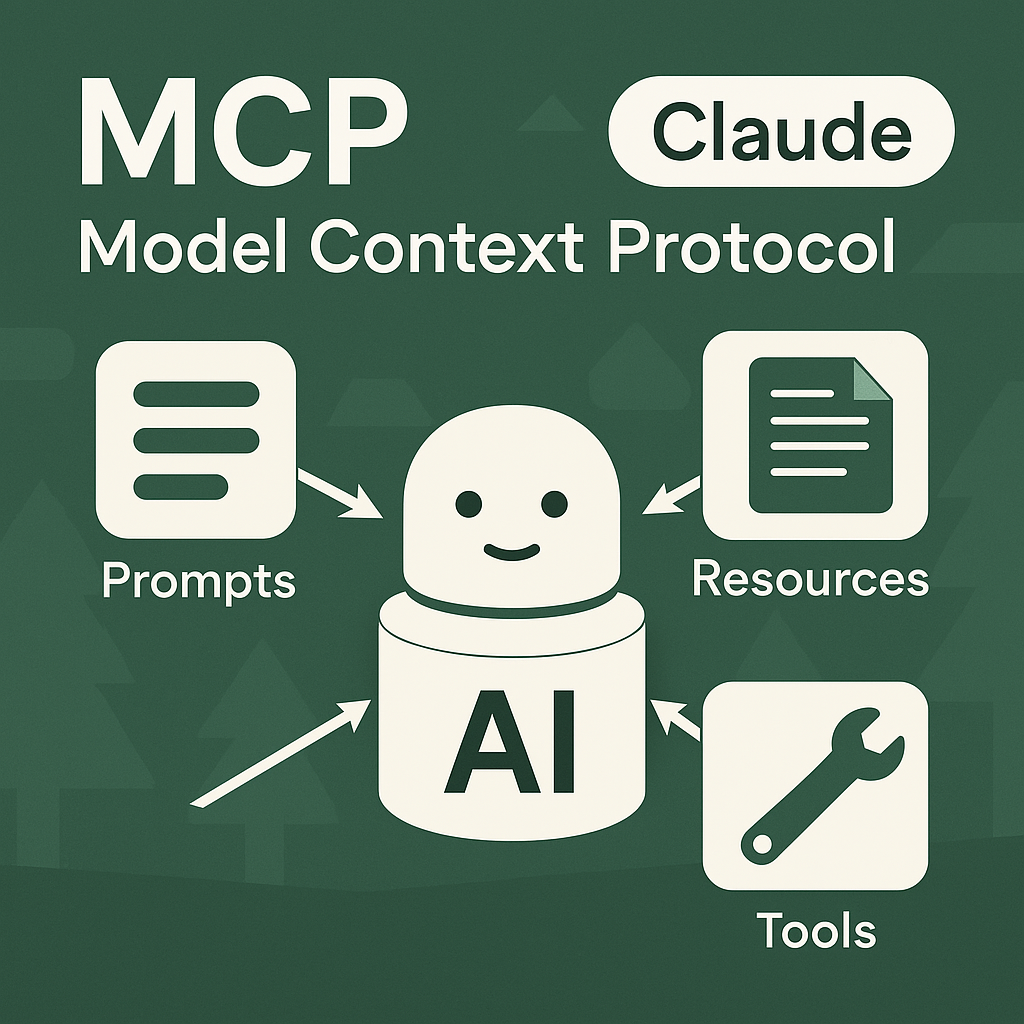

ClaudeはMCPと組み合わせることで、コンテキストを単なるテキスト列ではなく、構造化された要素として扱います。具体的には以下の3種類の情報要素が定義されています:

- プロンプト(Prompts)

モデルへの指示文やテンプレート的役割。システムメッセージやユーザーの質問雛形などを含む。 - リソース(Resources)

参照可能な外部データを指し、読み取り専用の情報(URIで指定)。例:ドキュメント本文、データベースレコード、Wikiページなど。 - ツール(Tools)

モデルが呼び出せる関数やAPI。実行可能な機能であり、たとえば計算処理や外部Webサービス呼び出しなどを想定。

MCPでは「プロンプト」「リソース」「ツール」を明示的に切り分けてモデルに与えるため、どの情報が指示なのか、どの情報が参照データなのかをモデルが誤解しにくい設計になっています。

2-3. 動的な情報取得とインタラクティブ性

MCP経由でClaudeは必要に応じてツールを呼び出し、外部データを取得したり別のアクションを実行することができます。たとえばユーザーが「最新の在庫データを確認してレポートを出して」と依頼すると、ClaudeはMCPサーバーとしてのデータベースへアクセスを指示し、取得した情報をリソースとしてコンテキストに組み込み、回答を生成します。

このようにコンテキストは**対話中に拡張可能な“動的リソース”**となり、さらにセキュリティ管理もホストアプリケーション側で容易に行えるのが利点です。

2-4. Claude+MCPがもたらす利点の要約

- 桁違いの長い文脈保持: 最大100Kトークンという膨大なテキストを一括で処理可能。

- コンテキストの構造化: 「プロンプト」「リソース」「ツール」ごとの役割をはっきり分け、誤解を減らす。

- 動的な情報取得: AIが自発的に追加情報を取りに行き、回答をより正確・最新化できる。

- セキュアな連携: オープンプロトコル&JSON-RPCによる標準化+ホスト側のアクセス権限管理。

3. 他のAIシステム(OpenAI ChatGPTやGoogle Gemini)とのコンテキスト処理の違い

3-1. コンテキストウィンドウの長さ

Claudeの100Kトークンは長らく商用最大級でしたが、OpenAIが2023年末のDevDayで発表したGPT-4 Turboは128Kトークンに対応し、GoogleのGemini 1.5も128K〜100万トークン規模を目指すと発表しています。

今後は各社がコンテキスト容量を強化していく流れですが、MCP自体はモデルに依存しない標準なので、仮にClaudeや他モデルがさらにコンテキストを伸ばしても、MCPを通じて同様の方法で連携を維持できます。

3-2. 構造化とツール呼び出し(Function Calling)との比較

OpenAIのGPT-4 APIにも「関数呼び出し(Function Calling)」機能がありますが、これはOpenAI独自の方式で、関数をJSONスキーマで定義し、プラグインもChatGPT内部で動く形です。他のモデルとの互換性はありません。

MCPは**「どのAIモデルでも共通の手順でデータやツールへアクセスできる」**という設計が特徴です。天気情報などのAPIをMCPサーバー化すれば、ClaudeだけでなくMCP対応の他AIでも使い回せるため、一度の実装で汎用利用が可能です。

3-3. クローズドなプラットフォーム拡張 vs オープン標準

ChatGPTプラグインやBardのGoogle連携は、あくまで各プラットフォーム内の独自拡張という色が強く、標準化の動きはありません。対してMCPは最初からオープンソースで公開され、どのモデルやアプリケーションでも使えるように設計されています。

この違いは開発者にとってベンダーロックインを回避しやすい点や、コミュニティ主導でコネクタを増やせる点で非常に大きなメリットとなっています。

3-4. 会話の持続性と外部ストレージ利用

ChatGPTなども同じスレッド内で過去のメッセージを参照しますが、非常に長い会話では古い内容が要約・切り捨てされがちです。また別セッションでは文脈が引き継げません。MCPでは、会話ログDBのような外部ストレージをリソースとして標準化できるため、必要に応じて長期的にコンテキストを復元可能です。

OpenAIも「永続的メモリ」機能を検討していますが、MCPはモデル外で安全に会話履歴を保管し、必要時のみモデルに供給する手法を容易にします。

4. MCPの新規性と開発者への利点:統一規格が拓く可能性

4-1. 「標準化」による統合の容易化

従来、AIと新たなデータソースをつなぐたびに、モデルごとに連携方法を実装する必要がありました。MCPはこれを大幅に軽減します。一度アプリがMCPクライアントに対応すれば、新しいMCPサーバーが追加されても実装作業なくすぐ使えるのです。

開発者は、面倒な外部連携コードを書く手間を削減でき、本来のアプリケーションロジックに集中できます。

4-2. エコシステムの拡大と再利用性

オープンプロトコルであるMCPには、コミュニティや企業が様々なサーバー実装を公開しはじめています。SlackやGitHub、Google Drive、Postgresなど主流サービス向けMCPサーバーがすでに提供されており、**「作ればみんなが使える」**という再利用性の高さが魅力です。

MicrosoftもC# SDKを共同開発するなど、大手企業もこぞって参入しています。今後さらに多くのコネクタが生まれることで、MCP対応AIがあらゆるツール・データを取り込めるエコシステムが広がるでしょう。

4-3. 設計パターンの統一:クライアント・サーバー分離

MCPによって「データ取得(Resources)」「操作呼び出し(Tools)」「モデルへの指示(Prompts)」が明確に分離され、各部分の責務がはっきりします。たとえば「データアクセスの改善」はサーバー側、「モデル応答の制御」はクライアント側など、アーキテクチャ的に役割を整理できるのが利点です。

この「関心の分離」を標準化することで、開発の見通しや保守性が高まります。

4-4. エージェント的AIを支える基盤

MCP経由でツールを呼び出せるのは、エージェント的AIを構築するうえでも重要です。モデルが自発的に行動を計画し、外部アクションを実行し、その結果を再びコンテキストに取り込みながらタスクを進める――こうした高度なやり取りが、MCPで標準化されたインタフェースを用いて安全に行えます。Anthropicも「MCPはエージェントフレームワークの実装を容易にする」と述べています。

5. MCPの応用例と今後の展望:長文処理から知識検索、持続的会話まで

5-1. 大容量ドキュメント解析・要約

長大なコンテキスト処理とMCPの組み合わせは、数百ページに及ぶ文書の分析・要約にうってつけです。Anthropicのデモでは、5.8万語のポッドキャスト文字起こしをClaudeに一括読み込みさせ、短時間で要点を抽出させることに成功しています。

契約書や研究論文など膨大な文書を瞬時に理解・要約できるため、法務や学術、金融レポート分析など、幅広い業務で役立つでしょう。

5-2. 社内RAG(Retrieval Augmented Generation)での活用

RAGとは、モデルが回答を生成する際に外部の知識ソースを検索(Retrieve)して結果を組み込む手法です。MCPはRAGの実装を標準化する格好のプロトコルになります。

社内ナレッジベースやWeb検索サービスをMCPサーバーにし、Claude(クライアント)が自動で外部リソースを検索して回答に反映できます。これにより、最新データを逐次参照した正確なQ&Aが可能です。

5-3. 継続的な会話・パーソナルアシスタント

MCPを使うと、長期にわたる会話の文脈や個人設定を外部ストレージで保持し、必要に応じて読み込むことができます。営業支援AIであれば、顧客の商談履歴や過去のリクエストを参照しながら文脈を継続して対話できるため、よりパーソナライズされた提案が可能になります。

プライバシー保護の面でも、データをローカルやプライベートクラウドに置いたままMCPサーバー化できるので、安全性と利便性を両立しやすいです。

5-4. コーディング支援・ソフトウェア開発への応用

MicrosoftのVS CodeやGitHub CopilotなどもMCP対応が進んでいます。開発者が使うエディタでAIがコード提案やリファクタリングを行う際に、リポジトリ全体・テスト結果・ビルドツールなどをMCPサーバー経由で参照でき、プロジェクト全体の文脈を把握したうえでの高度な支援が可能になります。

5-5. 複数システムを横断するエージェント的ワークフロー

MCPサーバーとしてSlackチャットやウェブブラウザ操作ツール(Playwright)などを実装し、AIがそれらを組み合わせて複合タスクを自動化することも視野に入ります。たとえばカレンダーをチェックし、最適な会議日程を決めてメール送信までする――という一連のプロセスをAIが行えるようになるわけです。

将来的には**「社内システムすべてがMCPサーバー化され、AIが横断的に情報を活用しながら作業する」**世界観も見えています。

6. 今後の展望:業界標準プロトコルとしての可能性

6-1. 急速に広がる採用と「事実上の標準」化

MCPは公開から日が浅いながらも、急速に採用例が増えています。Anthropicは「MCPは様々なツールやデータを一貫した形で扱える普遍的な基盤になる」と述べ、業界に広く普及させる方針を強調しています。

もしMCPが事実上の標準となれば、**「どんなAIでもMCP対応さえすれば様々な外部サービスやデータを自由に扱える」**世界が実現するでしょう。

6-2. 大容量コンテキスト+マルチモーダル化への対応

Google Geminiがマルチモーダルに対応するなど、モデル側もテキスト以外の入力(画像や音声、動画)を扱う流れが加速しています。MCPも画像や音声をリソースとして扱える拡張が検討されており、将来的に映像データやセンサー情報をAIが解析して活用する可能性があります。

エンタープライズやIoT分野での応用も期待でき、**「MCPでつながったAIがリアルタイムのセンサー情報をもとに判断する」**といった高度なシステムも視野に入ります。

6-3. AI秘書の実現とベンダーロックイン解消

MCPはベンダーロックインを避けながら、企業やユーザが自由に自社データをAIに連携させることを可能にします。将来的には「個人や組織が使う全サービスがMCP対応になり、任意のAI秘書が横断的にサポートする」形が理想像として描かれています。

たとえば数年後には、仕事でもプライベートでも「各種ツールを勝手に連携・操作し、ユーザの必要に応じてあらゆるデータを統合してくれるAIアシスタント」が当たり前になるかもしれません。その裏で働くのがMCPという統一プロトコルというわけです。

まとめ

ClaudeにおけるMCP(Model Context Protocol)は、AIの文脈利用を飛躍的に強化する革新的な技術基盤です。オープンな標準プロトコルとして、

- 膨大なコンテキストを活かした上で

- 外部データやツールを安全に構造化して扱い

- AIが自発的かつ動的に情報取得・アクション可能な環境を整える

というメリットをもたらします。業界ではOpenAIやGoogleも長大コンテキストやツール連携を進めていますが、それらはクローズドな仕組みや独自プラットフォームにとどまっている場合が多いです。

一方、MCPは「どのAIでも簡単に連携できる」という明確なビジョンを掲げ、オープンソースと標準化を武器に急速に普及を進めています。もし今後MCPが広く採用されれば、私たちの仕事や生活の中でAIが複数のデータソースを横断し、文脈を切らさず高度な支援を行う――そんな真のスマートアシスタントの世界が実現に近づくでしょう。